728x90

반응형

인공지능 기술(3)

자막&음성

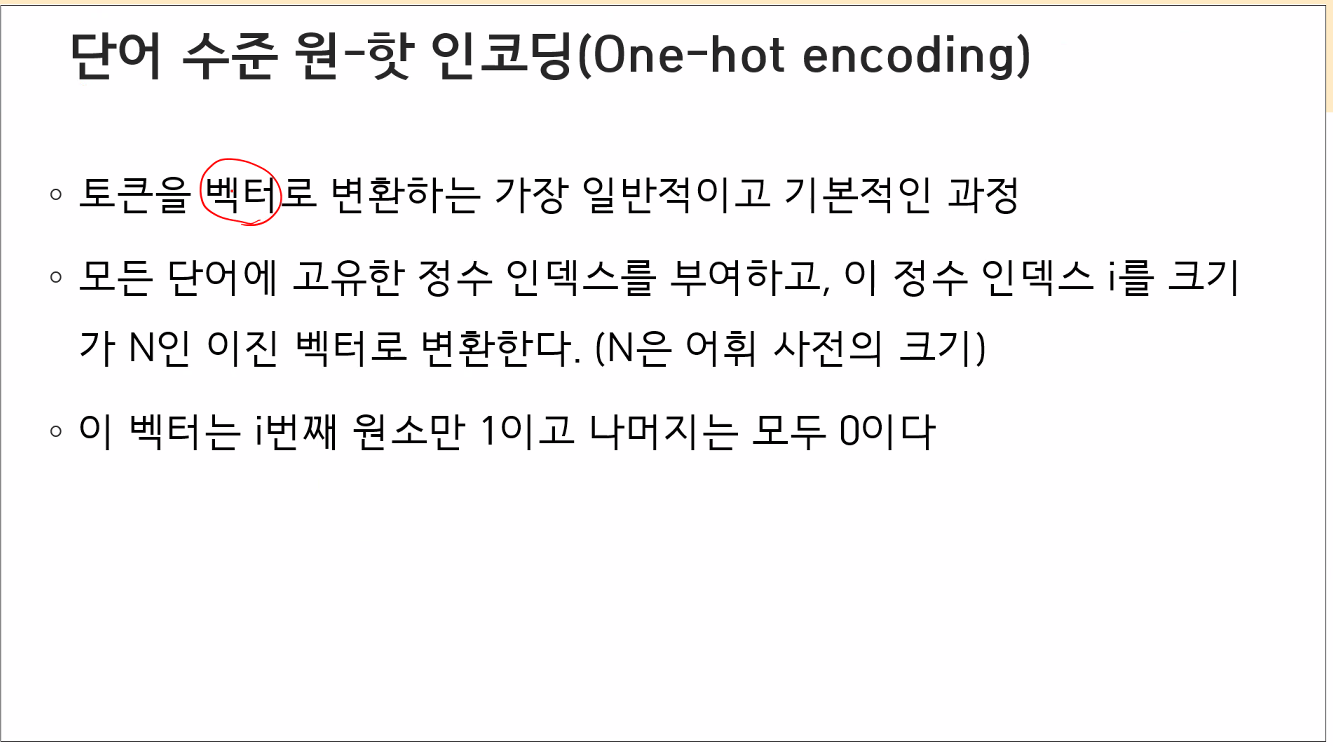

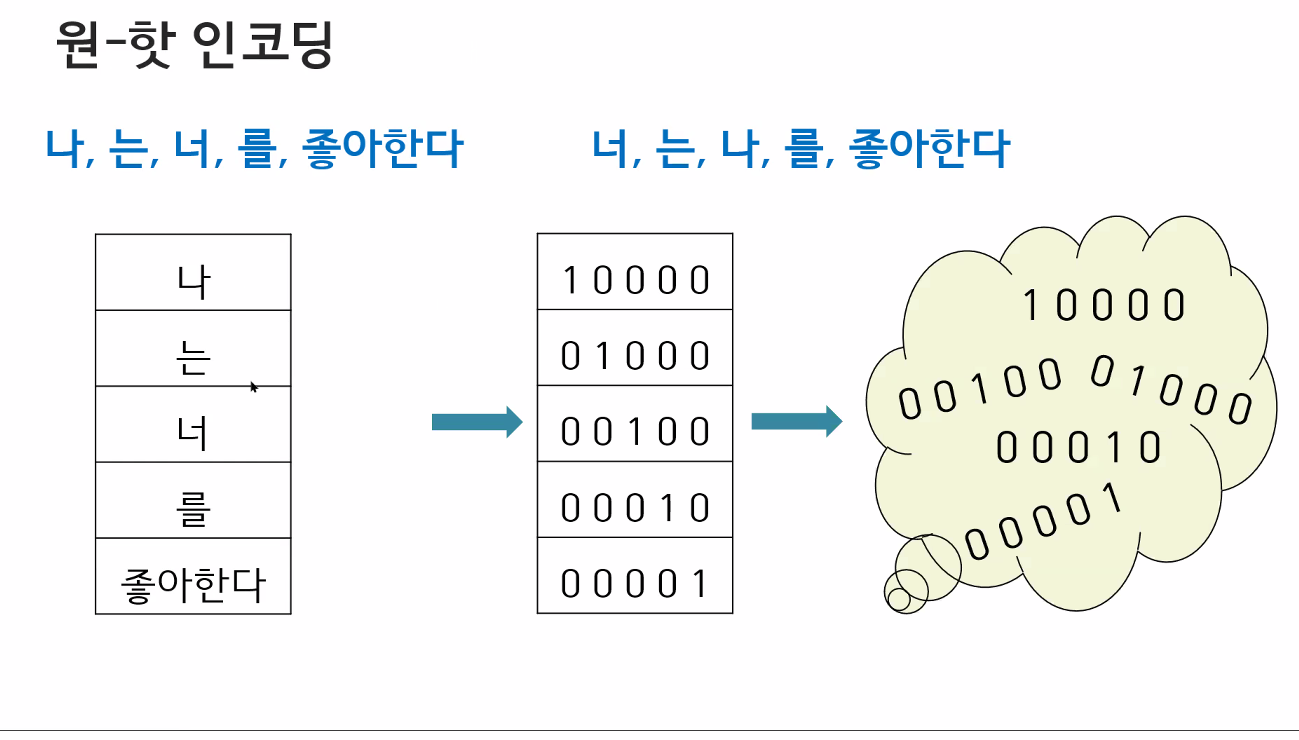

10010 ->n이 너무 커져..

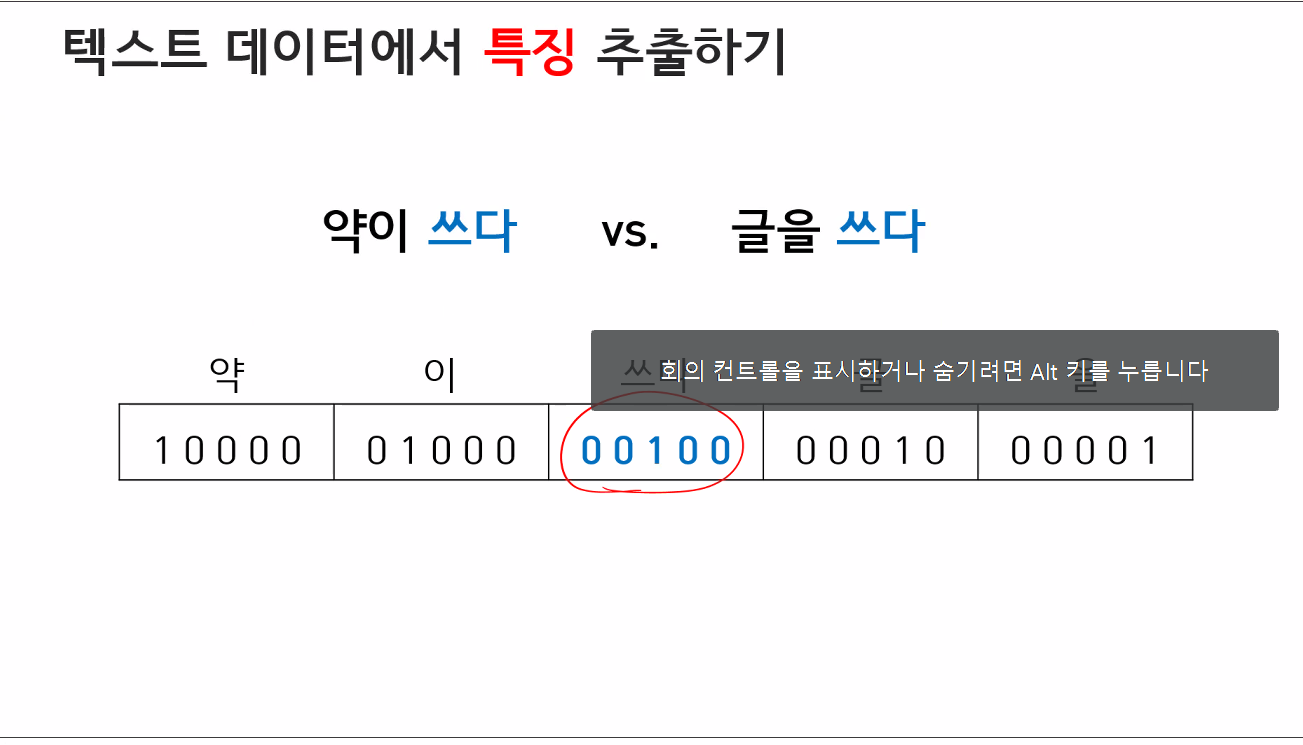

동의어 처리에 문제가 생길 것 같음.

100000000 ->공간낭비가 너무 심해 (0)

sparse 희소행렬... 메모리 낭비가 커짐

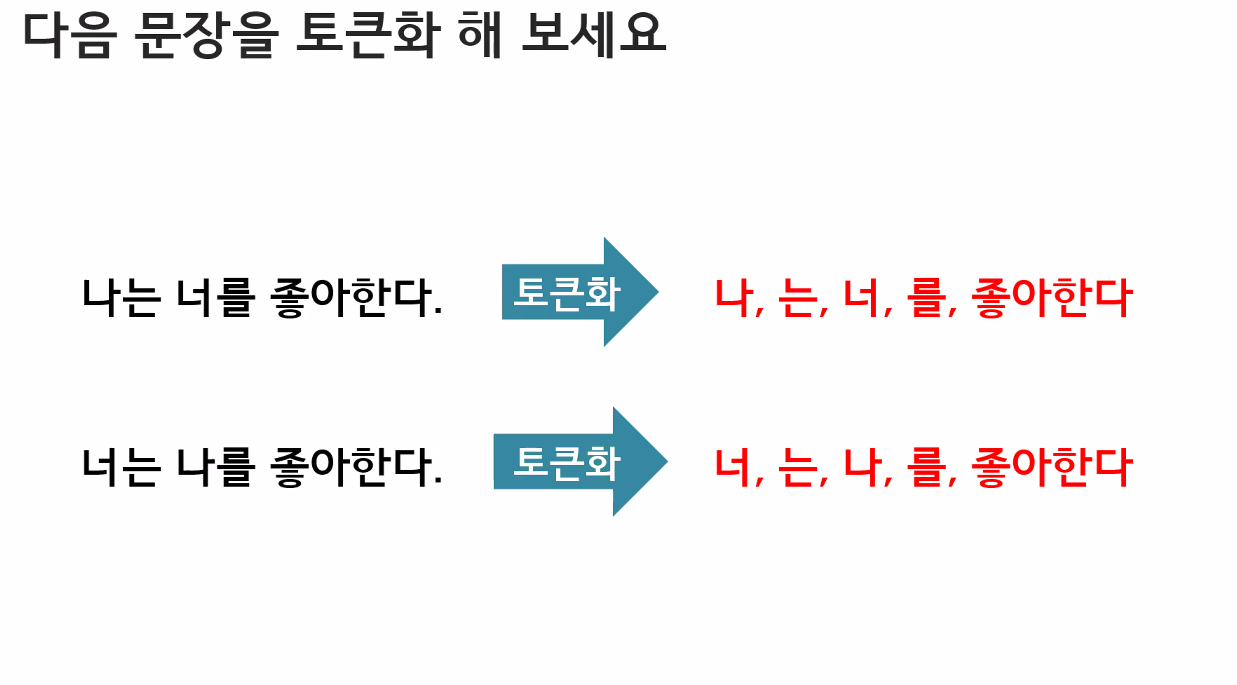

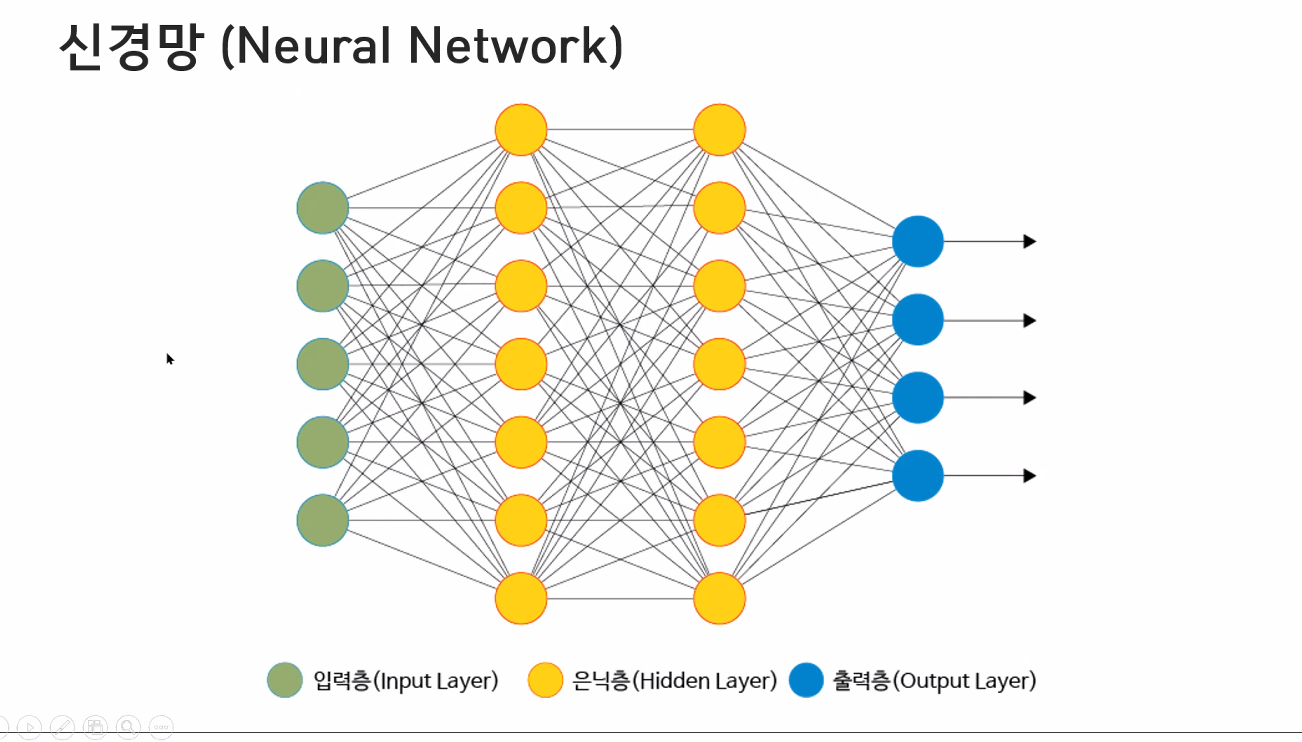

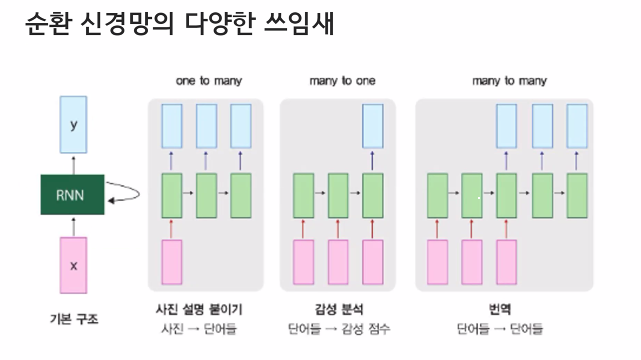

입력 -> 출력

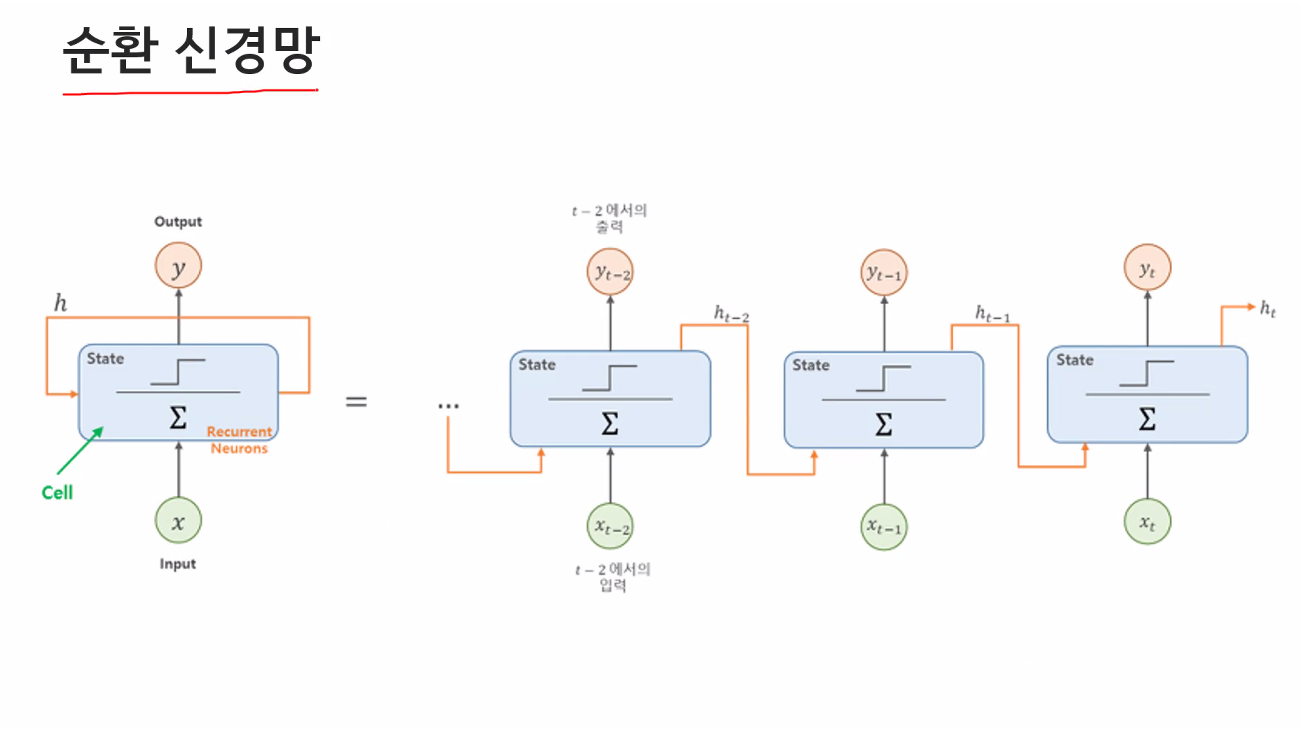

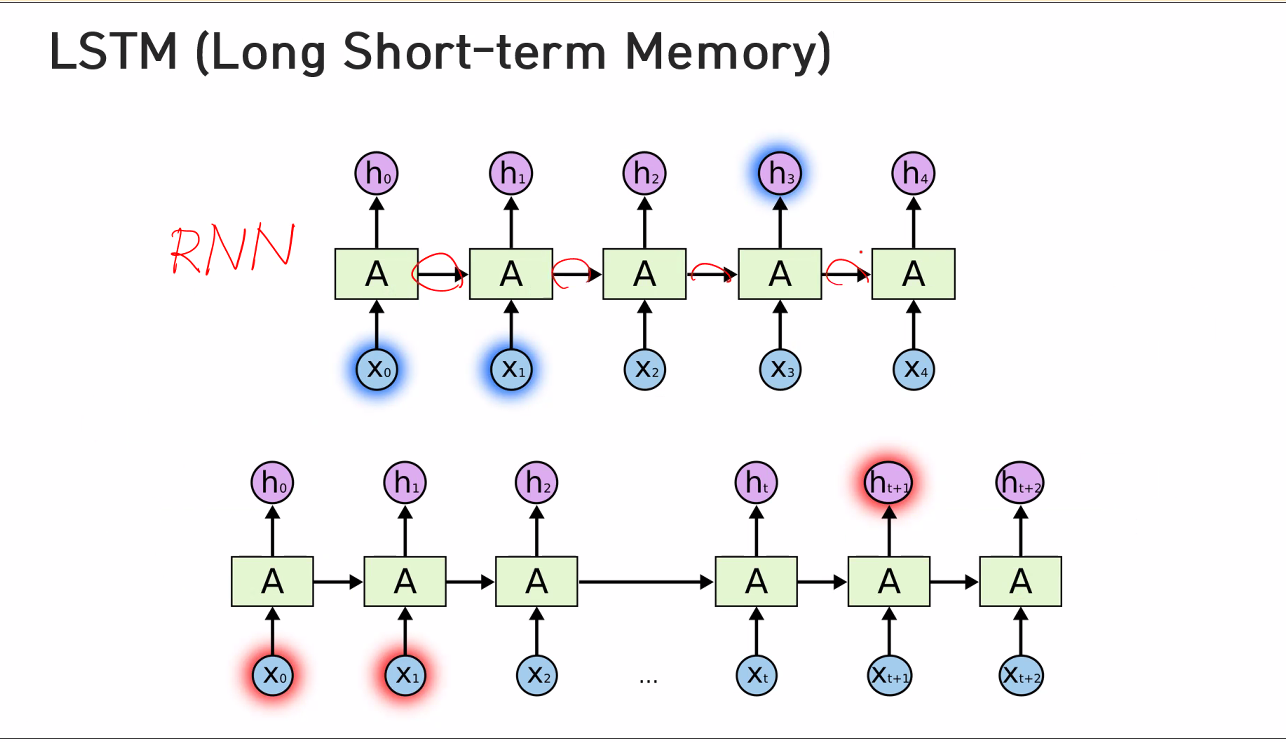

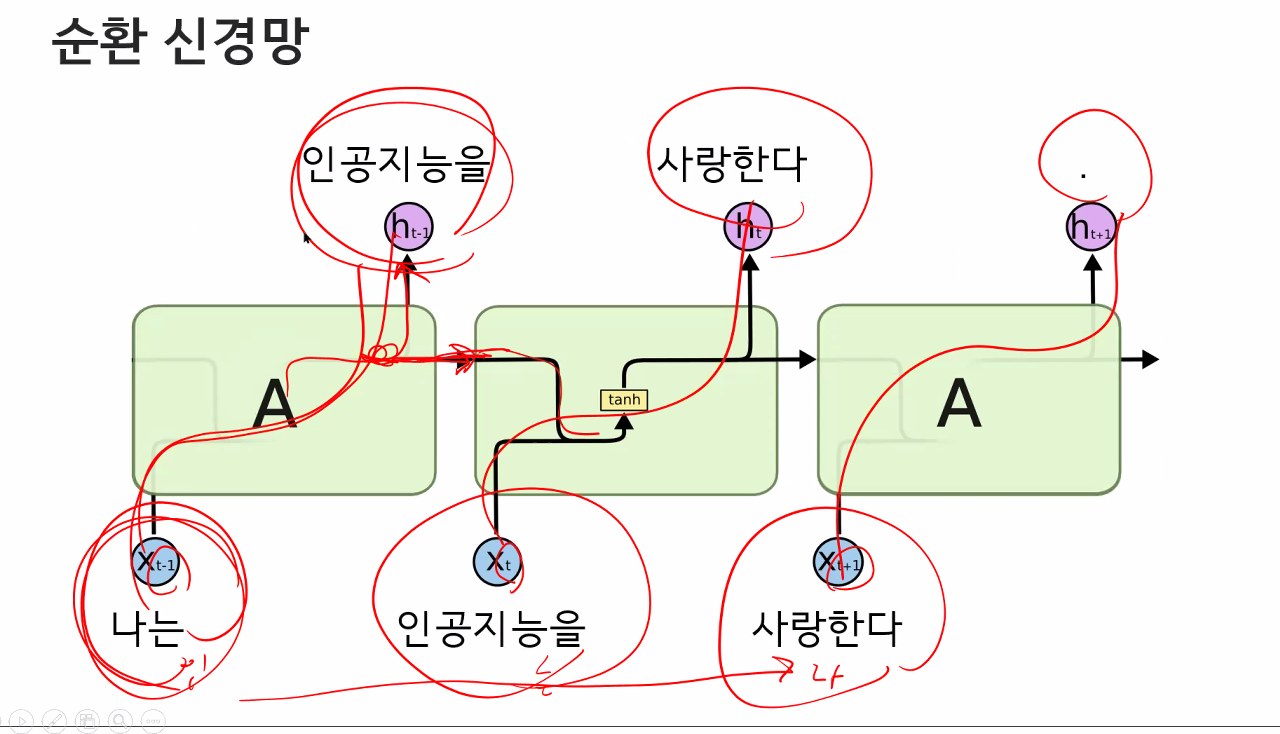

RNN

자신한테 돌아옴.

아니요..ㅁ

은닉층.

어떤 일, 계싼에 ㅇ의해서 결과물이 나온지 몰라요..

왜 그렇게 생각했는데... 이거에 대해 답을 할 수 있는데.. 나름 이유를 가지고 있는데

인공지능은 긍정 부정 답을 내놨는데 왜 그렇게 나왔는지 대답을 못해.

그냥 계산해보니... 나온거거든..

학습에 사용된 데이터들이 인간의 데이터를 이용한 거기 떄문이야..

인공지능의 정의조차 사람들마다 다르니.. 다른 읙ㄴ이 없게어요?

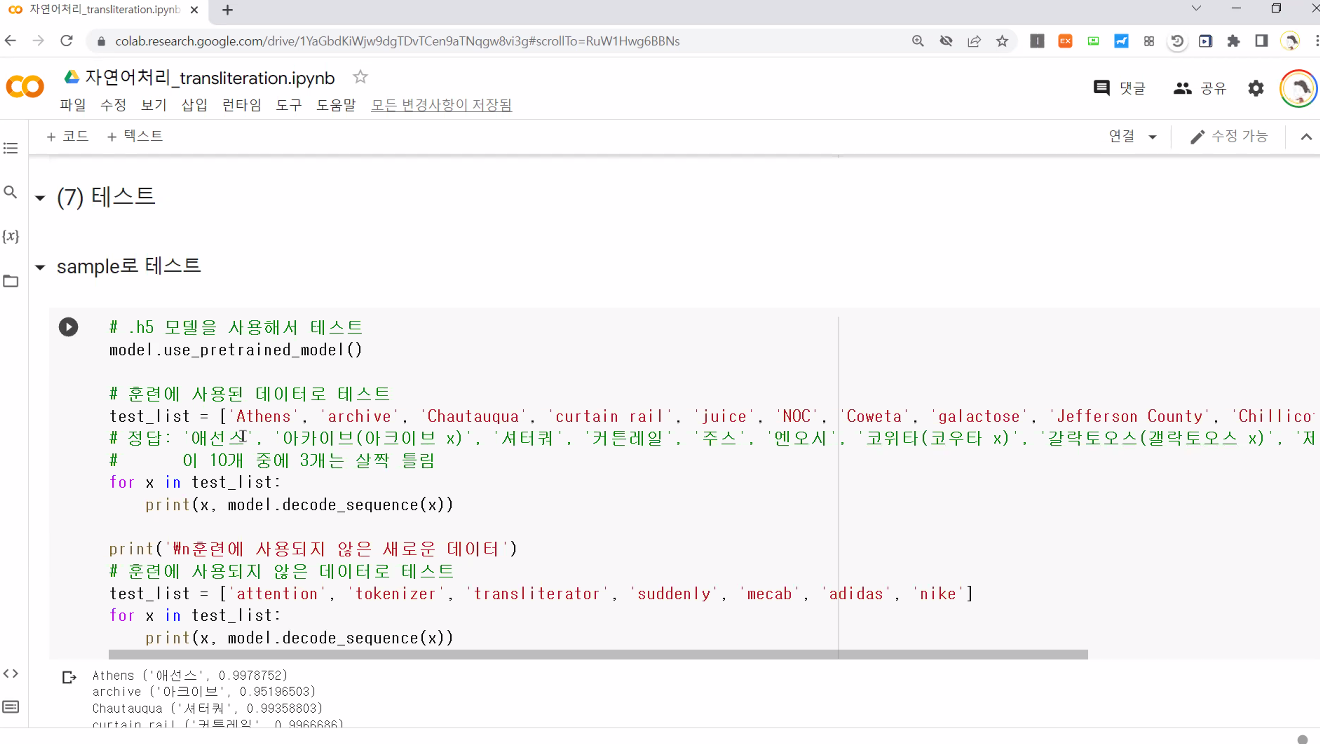

인공지능 봇이 쓴 기사임.

경사하강법?

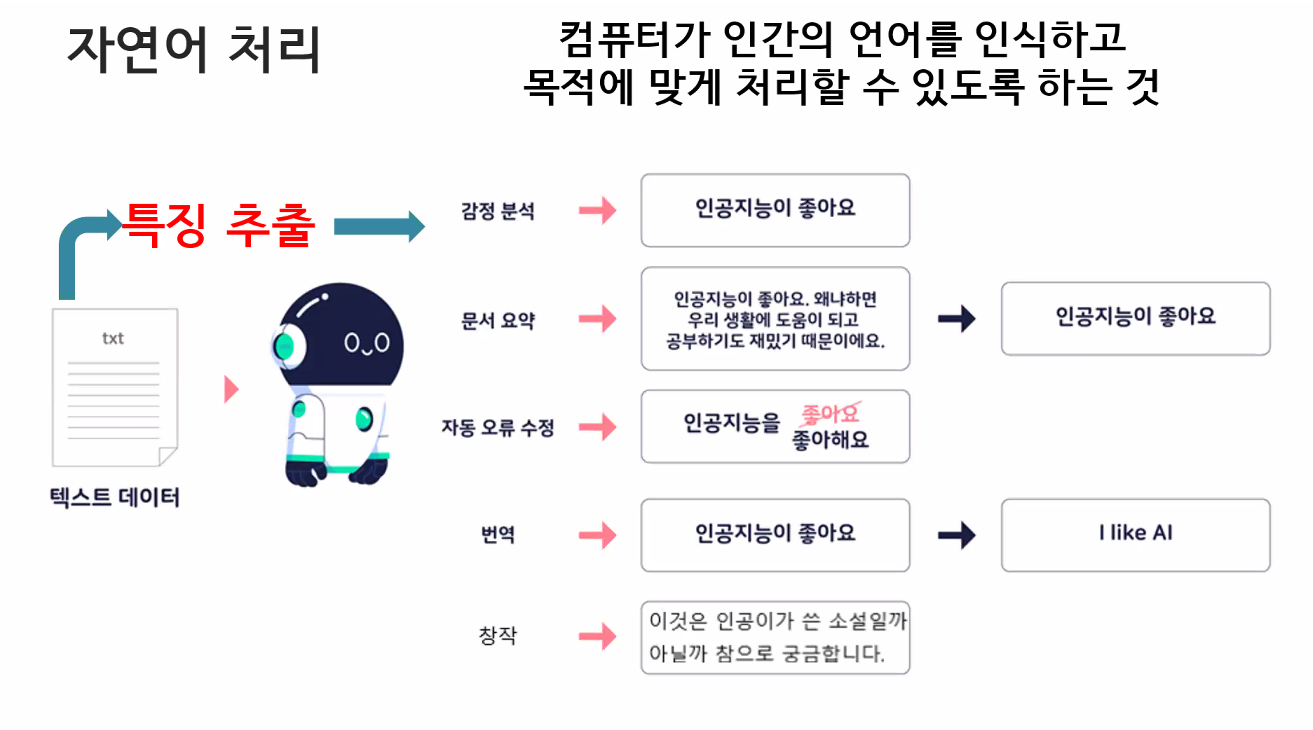

자연어 처리는 00입니다.

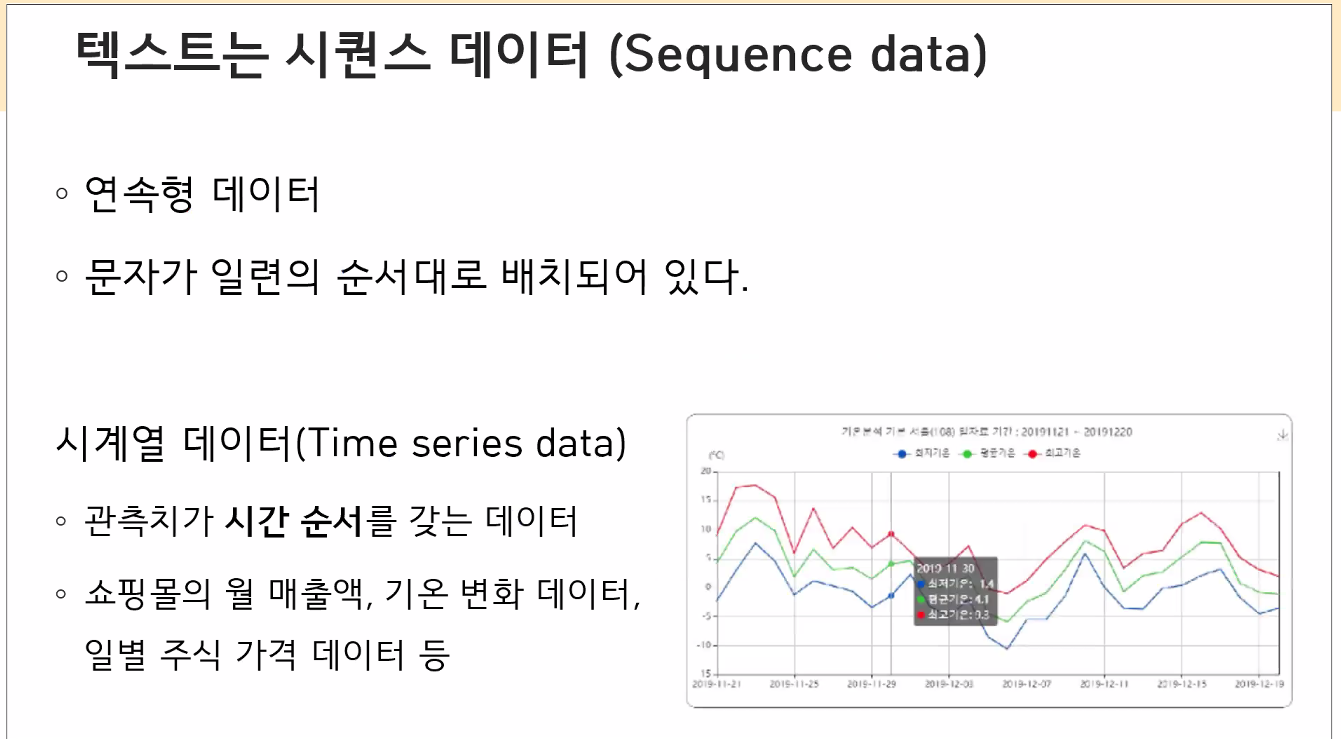

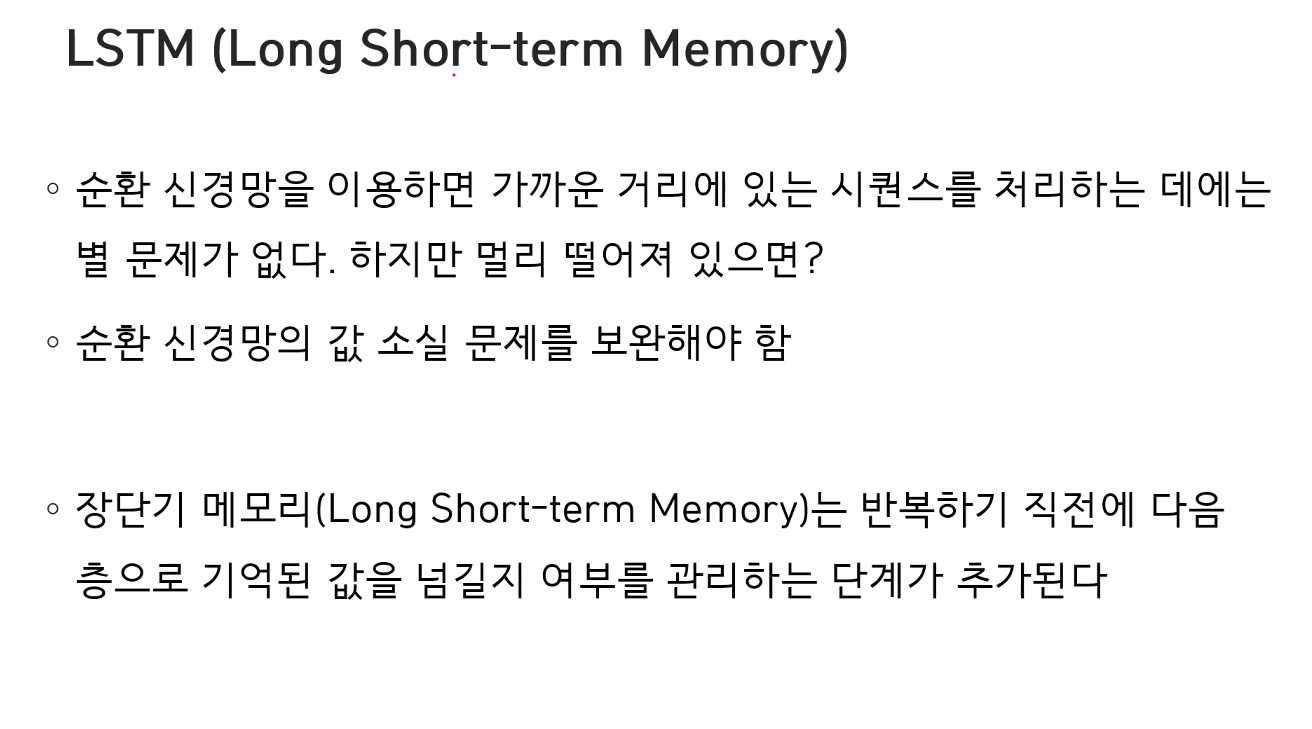

자연어 처리는 0000이고 0000이고 0000이고0000입니다. 라고 했을 때 오래된 기억들은 머리에서 사라지는 것과 같이 처음에 들어온 정보는 .. 영향을 주지만 너무 길어지만 영향이 점점 줄어들어 정보가 사라지게 된다.

RNN의경우에는 이런 문제가 있어서

LSTM 장기기억 단기기억 구조를 쓰임

순

728x90

반응형

댓글